O Google está implementando uma série de novas funcionalidades no Gemini Live, seu assistente de inteligência artificial projetado para conversas em tempo real. Estas atualizações visam aprimorar a interação do usuário com a IA, tornando-a mais intuitiva e contextualizada. As novidades incluem guias visuais diretas na tela, integração expandida com aplicativos essenciais do sistema e um modelo de áudio aprimorado para uma comunicação mais natural.

O Gemini Live permite que os usuários mantenham diálogos fluidos com o assistente, utilizando a voz para comandos e perguntas. A capacidade de processar informações em tempo real e responder de forma conversacional é um pilar central da experiência. As próximas funcionalidades expandem essa interação para além do áudio, incorporando elementos visuais e aprofundando a conectividade com o ecossistema do smartphone.

Orientação Visual Direta na Tela

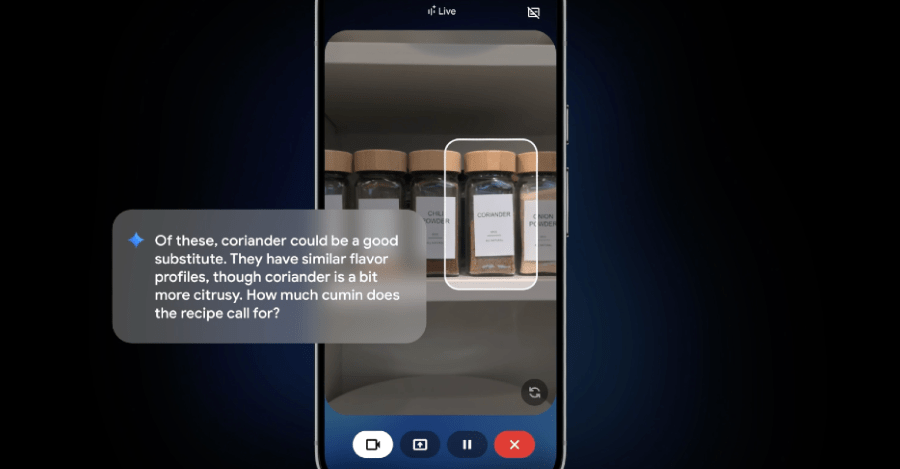

Uma das principais inovações que chegam ao Gemini Live é a capacidade de destacar elementos diretamente na tela do dispositivo enquanto o usuário compartilha a câmera. Este recurso permite que o assistente de IA aponte para um item específico em tempo real, oferecendo uma camada adicional de clareza e precisão na comunicação.

A funcionalidade opera quando o usuário aponta a câmera do seu smartphone para um objeto ou um conjunto de objetos. O Gemini Live, utilizando sua capacidade de reconhecimento visual, identifica os itens e pode sobrepor um destaque visual, como uma caixa ou um realce, sobre o objeto de interesse na tela do usuário. Simultaneamente, o assistente pode fornecer feedback verbal, confirmando o item destacado ou oferecendo informações adicionais sobre ele.

Por exemplo, se um usuário está procurando uma ferramenta específica em uma caixa de ferramentas desorganizada, ele pode apontar a câmera do seu smartphone para a coleção. O Gemini Live, ao processar a imagem, pode identificar a ferramenta correta e destacá-la visualmente na tela, facilitando a localização. Este tipo de interação visual é projetado para simplificar tarefas que exigem identificação de objetos, montagem de itens ou navegação em ambientes complexos.

Outras aplicações práticas incluem a identificação de componentes em um aparelho eletrônico, a localização de um ingrediente específico em uma despensa cheia, ou o reconhecimento de uma planta em um jardim. A capacidade de o assistente “mostrar” o que está falando, em vez de apenas descrever, pode reduzir a ambiguidade e acelerar a resolução de problemas ou a conclusão de tarefas.

A implementação inicial deste recurso de orientação visual está prevista para os novos dispositivos Pixel 10, com lançamento agendado para 28 de agosto. Após a estreia nos aparelhos Pixel, o Google começará a expandir a disponibilidade da guia visual para outros dispositivos Android. Em um cronograma subsequente, a funcionalidade será estendida para dispositivos iOS nas semanas seguintes, garantindo uma ampla acessibilidade da inovação.

Esta abordagem multimodal, que combina entrada de áudio, processamento de linguagem natural e reconhecimento visual com feedback visual direto, representa um avanço na forma como os usuários interagem com assistentes de inteligência artificial. O objetivo é tornar a comunicação com a IA mais natural e eficiente, espelhando a forma como os humanos interagem com o mundo ao seu redor.

Integração Contextual com Aplicativos Essenciais

Além das melhorias visuais, o Google está lançando novas integrações que permitirão ao Gemini Live interagir com uma gama mais ampla de aplicativos essenciais do sistema. Em breve, o assistente poderá se conectar e operar com aplicativos como Mensagens, Telefone e Relógio, expandindo sua utilidade para além das conversas informativas.

Esta integração significa que o Gemini Live poderá realizar ações dentro desses aplicativos com base no contexto da conversa atual do usuário. A capacidade de transitar entre diferentes tarefas e aplicativos sem quebrar o fluxo da conversa é um ponto central desta atualização. O assistente é projetado para manter o contexto da interação, permitindo que o usuário altere o foco da conversa e solicite ações relacionadas a outros aplicativos de forma fluida.

Um exemplo prático ilustra essa funcionalidade: imagine que um usuário está conversando com o Gemini Live sobre as direções para um destino. Durante a conversa, o usuário percebe que pode se atrasar. Em vez de ter que sair do Gemini Live, abrir o aplicativo de mensagens e digitar uma nova mensagem, o usuário poderá simplesmente interromper o assistente com um comando como: “Esta rota parece boa. Agora, envie uma mensagem para o Alex dizendo que vou atrasar uns 10 minutos.”

Nesse cenário, o Gemini Live, compreendendo o contexto da conversa e a nova solicitação, poderá rascunhar uma mensagem de texto para o contato especificado, incorporando a informação do atraso. O usuário então teria a opção de revisar e enviar a mensagem. Esta capacidade de “interrupção” e transição de tarefas é fundamental para uma experiência de usuário mais eficiente e menos fragmentada.

As integrações não se limitam a mensagens. O Gemini Live também poderá auxiliar em tarefas relacionadas ao aplicativo Telefone, como iniciar chamadas, e ao aplicativo Relógio, como definir alarmes ou lembretes. Por exemplo, se o usuário estiver discutindo um evento futuro, poderá pedir ao Gemini Live para “definir um lembrete para uma hora antes do evento” ou “ligar para [nome do contato] para confirmar os detalhes”.

Esta expansão da conectividade com aplicativos essenciais visa transformar o Gemini Live em um assistente mais abrangente e proativo, capaz de gerenciar múltiplas facetas da vida digital do usuário. A capacidade de executar ações em diferentes aplicativos sem a necessidade de alternância manual entre eles representa um passo significativo em direção a uma interação mais integrada e intuitiva com a inteligência artificial.

Modelo de Áudio Avançado para Conversas Mais Naturais

A terceira grande atualização do Google para o Gemini Live envolve um modelo de áudio aprimorado. A empresa afirma que este novo modelo “melhorará dramaticamente” a forma como o chatbot utiliza elementos-chave da fala humana, como entonação, ritmo e tom. O objetivo é tornar as interações de voz com o assistente ainda mais naturais e expressivas.

Tradicionalmente, a síntese de voz de assistentes de IA pode soar robótica ou monótona. Com este novo modelo de áudio, o Gemini Live é projetado para modular sua voz de forma mais dinâmica, refletindo as nuances da comunicação humana. Isso significa que o assistente poderá ajustar seu tom de voz com base no tópico da conversa ou no contexto emocional implícito na fala do usuário.

Por exemplo, se um usuário estiver discutindo um tópico estressante ou sensível, o Gemini Live poderá adotar uma voz mais calma e compassiva. Se a conversa for sobre algo empolgante, o tom do assistente poderá refletir entusiasmo. Esta adaptação do tom de voz visa criar uma experiência de conversação mais empática e envolvente, tornando a interação com a inteligência artificial mais próxima de um diálogo humano.

Além da modulação automática do tom, os usuários também terão a capacidade de personalizar a velocidade da fala do Gemini Live. Esta funcionalidade permite que o usuário ajuste se o assistente fala mais rápido ou mais devagar, adaptando-se às preferências individuais de audição ou às necessidades de compreensão em diferentes situações. Esta flexibilidade na velocidade da fala é um recurso que já existe em outras plataformas de IA conversacional e é valorizado por usuários que preferem um ritmo de comunicação específico.

Outra característica notável do modelo de áudio atualizado é a capacidade do Gemini Live de adotar sotaques. Se um usuário solicitar ao assistente uma recontagem dramática de uma história da perspectiva de um personagem específico ou de uma figura histórica, o chatbot poderá incorporar um sotaque apropriado para enriquecer a narrativa. Esta funcionalidade é voltada para aprimorar a experiência de storytelling e tornar as interações mais imersivas e divertidas.

As melhorias no modelo de áudio representam um esforço contínuo para refinar a qualidade da voz sintetizada e a expressividade dos assistentes de IA. Ao incorporar mais elementos da fala humana, o Google busca criar uma experiência de usuário que não apenas seja funcional, mas também agradável e natural, facilitando a comunicação e a compreensão entre humanos e inteligência artificial.

Avanços na Interação com Inteligência Artificial

As atualizações do Google para o Gemini Live demonstram um foco na evolução da interação entre usuários e inteligência artificial. A integração de guias visuais, a expansão da conectividade com aplicativos essenciais e o aprimoramento do modelo de áudio são passos que visam tornar o assistente mais versátil e intuitivo.

A capacidade de o Gemini Live destacar informações visuais na tela enquanto o usuário compartilha a câmera representa um avanço na comunicação multimodal. Esta funcionalidade permite que o assistente forneça feedback visual direto, complementando as respostas de áudio e texto. A aplicação prática abrange desde a identificação de objetos até a assistência em tarefas complexas que exigem reconhecimento visual.

A integração com aplicativos como Mensagens, Telefone e Relógio expande a utilidade do Gemini Live para além das consultas informativas. A capacidade de o assistente realizar ações contextuais dentro desses aplicativos, como rascunhar mensagens ou definir lembretes, otimiza o fluxo de trabalho do usuário e reduz a necessidade de alternar manualmente entre diferentes interfaces. Isso contribui para uma experiência mais coesa e eficiente.

O novo modelo de áudio, com suas melhorias em entonação, ritmo e tom, busca humanizar a voz do assistente. A adaptação do tom de voz ao contexto da conversa e a capacidade de ajustar a velocidade da fala ou adotar sotaques para narrativas visam tornar as interações mais naturais e envolventes. Estas características contribuem para uma experiência de conversação mais agradável e expressiva.

As funcionalidades implementadas no Gemini Live refletem um compromisso com o desenvolvimento de assistentes de inteligência artificial que não apenas compreendam e respondam, mas também interajam de maneiras mais alinhadas com a comunicação humana. A disponibilidade inicial em dispositivos Pixel 10, seguida por uma expansão para outros dispositivos Android e iOS, indica uma estratégia para tornar estas inovações acessíveis a uma ampla base de usuários.

Fonte: https://www.theverge.com/news/763114/google-gemini-live-ai-visual-guidance-speech-update

Para seguir a cobertura, veja também 8217.